[新聞] AI新創公司Habana Labs挑戰英偉達訓練晶

作者: zxcvxx (zxcvxx) 2019-06-26 11:13:12

AI新創公司Habana Labs挑戰英偉達訓練晶片的解決方案

1.原文連結:https://bit.ly/2XzNtsU

2.原文內容:

![]()

AI新創公司Habana Labs推出首款用於雲端訓練的人工智慧處理器,稱為Gaudi HL-2000。

其聲稱該AI處理器的訓練系統的處理能力比起擁有相同數量的GPU系統還要高出4倍。

其實,Gaudi是Habana進軍AI市場的第二次嘗試成果。Habana在2018年第四季,向特定客

戶發送其第一款AI晶片Goya推理卡。這款產品與英偉達的V100 GPU相比,在ResNet-50上

進行推理運算時,以HL-1000驅動的Goya能提供超過四倍的吞吐量,兩倍的能源效率,以

及降低一半的延遲。

對Gaudi HL-2000而言,在ResNet-50模型中,每秒則可以處理1650張圖片,功耗幾乎是英

偉達Tesla V100的一半。因為根據測試,英偉達Tesla V100每秒約僅能處理600張圖片,

功耗為300W。

Habana並沒有提供太多關於晶片內部太多細節的資訊,只是聲稱它是基於第二代Tensor處

理核心(Tensor Processing Core, TPC)。此外,Gaudi處理器支持用於訓練的典型浮點

格式,例如:FP32和bfloat16,以及一些整數格式。封裝內記憶體則是採用32GB HBM2的

形式。

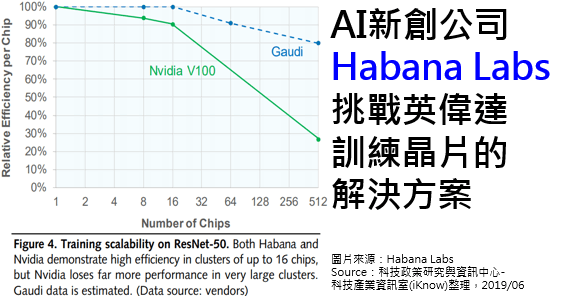

Gaudi最大的潛在優勢可能是它能夠大規模傳送性能,這對於建構更大、更複雜的神經網

路一直是一個挑戰。對於大多數訓練設定來說,一旦超出8或16個加速器,也就是說,一

旦你離開伺服器,性能就會趨於平緩。但是Gaudi卻不是如此。同樣的ResNet-50訓練可以

擴展至數百台HL-2000處理器,性能接近線性成長模式。與V100相比,Habana技術在650處

理器級別中,在吞吐量方面實現了3.8倍以上的優勢。

從產業趨勢來看,訓練AI模型每年需要以指數級成長的模式獲得更高運算能力,如此才能

夠滿足數據中心和雲端運算的迫切需求,進而大幅提高生產力和可延展性。現在憑藉著

Gaudi的創新架構,Habana可提供產業界最高的性能,同時整合基於標準的乙太網連接實

現無限擴展的可能。

總之,從評估系統到生產部署,這都是一條漫長的道路。如果Habana所宣稱的技術能夠按

照其承諾提供給產業界,AI市場的競爭模樣將變得不太一樣。畢竟,英偉達在AI硬體市場

,已經證明自己是一個能夠採取快速反應市場的公司。如果Habana想要在AI晶片市場獲得

更大的注目,就必須在激烈競爭的市場當中,證明自己的難耐。否則,曇花一現的新創公

司實在太多了,唯有真正展現範例,才是Habana能夠成為AI晶片大廠的第一步。

3.心得/評論:

這家AI新創公司宣稱其Gaudi HL-2000的性能優於英偉達的V100,雖然其晶片似乎擁有許

多潛在的優勢,但該公司在生產部署上仍是一條漫漫長路。

1.原文連結:https://bit.ly/2XzNtsU

2.原文內容:

AI新創公司Habana Labs推出首款用於雲端訓練的人工智慧處理器,稱為Gaudi HL-2000。

其聲稱該AI處理器的訓練系統的處理能力比起擁有相同數量的GPU系統還要高出4倍。

其實,Gaudi是Habana進軍AI市場的第二次嘗試成果。Habana在2018年第四季,向特定客

戶發送其第一款AI晶片Goya推理卡。這款產品與英偉達的V100 GPU相比,在ResNet-50上

進行推理運算時,以HL-1000驅動的Goya能提供超過四倍的吞吐量,兩倍的能源效率,以

及降低一半的延遲。

對Gaudi HL-2000而言,在ResNet-50模型中,每秒則可以處理1650張圖片,功耗幾乎是英

偉達Tesla V100的一半。因為根據測試,英偉達Tesla V100每秒約僅能處理600張圖片,

功耗為300W。

Habana並沒有提供太多關於晶片內部太多細節的資訊,只是聲稱它是基於第二代Tensor處

理核心(Tensor Processing Core, TPC)。此外,Gaudi處理器支持用於訓練的典型浮點

格式,例如:FP32和bfloat16,以及一些整數格式。封裝內記憶體則是採用32GB HBM2的

形式。

Gaudi最大的潛在優勢可能是它能夠大規模傳送性能,這對於建構更大、更複雜的神經網

路一直是一個挑戰。對於大多數訓練設定來說,一旦超出8或16個加速器,也就是說,一

旦你離開伺服器,性能就會趨於平緩。但是Gaudi卻不是如此。同樣的ResNet-50訓練可以

擴展至數百台HL-2000處理器,性能接近線性成長模式。與V100相比,Habana技術在650處

理器級別中,在吞吐量方面實現了3.8倍以上的優勢。

從產業趨勢來看,訓練AI模型每年需要以指數級成長的模式獲得更高運算能力,如此才能

夠滿足數據中心和雲端運算的迫切需求,進而大幅提高生產力和可延展性。現在憑藉著

Gaudi的創新架構,Habana可提供產業界最高的性能,同時整合基於標準的乙太網連接實

現無限擴展的可能。

總之,從評估系統到生產部署,這都是一條漫長的道路。如果Habana所宣稱的技術能夠按

照其承諾提供給產業界,AI市場的競爭模樣將變得不太一樣。畢竟,英偉達在AI硬體市場

,已經證明自己是一個能夠採取快速反應市場的公司。如果Habana想要在AI晶片市場獲得

更大的注目,就必須在激烈競爭的市場當中,證明自己的難耐。否則,曇花一現的新創公

司實在太多了,唯有真正展現範例,才是Habana能夠成為AI晶片大廠的第一步。

3.心得/評論:

這家AI新創公司宣稱其Gaudi HL-2000的性能優於英偉達的V100,雖然其晶片似乎擁有許

多潛在的優勢,但該公司在生產部署上仍是一條漫漫長路。

繼續閱讀

[新聞] 玉晶光決配息3.5元,Q2獲利向上Twinkling[標的] 3481 群創mayingnine[標的] 1232大統益是在漲什麼東西?pshuang[新聞] 金融戰開打?美媒:浦發銀行或因違禁被拒sunbysea[新聞] 〈財報〉美光Q3財報打敗預期 重啟向華為 kaiming7955[閒聊]2019/06/26 盤中閒聊justforsing[新聞] 矽晶圓訂單縮、現貨價崩 半導體產業下半kaube[公告] Arjuju99 moomoo91426 Chrkamp gyman7788noldorelf[公告] danie10424 hillgill Baumgartner水桶 noldorelf[公告] a11780922 STAV72 gemini2010水桶noldorelf